2024年12月17日(米国時間)、OpenAIは最新のAIモデル「OpenAI o1」やそのAPIを発表しました。新機能として、高度な推論能力、画像処理対応、リアルタイムAPIの強化、新しいファインチューニング手法などが導入されています。

主な新機能

1. 高度な推論能力を持つ「OpenAI o1」のAPI

- 関数呼び出し

o1を外部データやAPIと接続可能にし、よりシームレスなインテグレーションを実現。 - 開発者メッセージの指定

モデルのトーンやスタイル、行動指針をカスタマイズ可能。 - 画像対応

画像を元にした推論機能をサポート。 - パフォーマンスの向上

o1-previewよりも平均で60%少ないトークン消費で推論を実行。 - 新パラメータ「reasoning_effort」

推論にかける時間を制御し、効率的な処理を可能に。

2. リアルタイムAPIの改善

- WebRTCの統合

高速で安定したリアルタイム通信を実現。 - GPT-4oオーディオ価格の引き下げ

60%の価格削減により、より手軽な利用が可能。 - GPT-4o miniのサポート

軽量モデルでさらなる選択肢を提供。

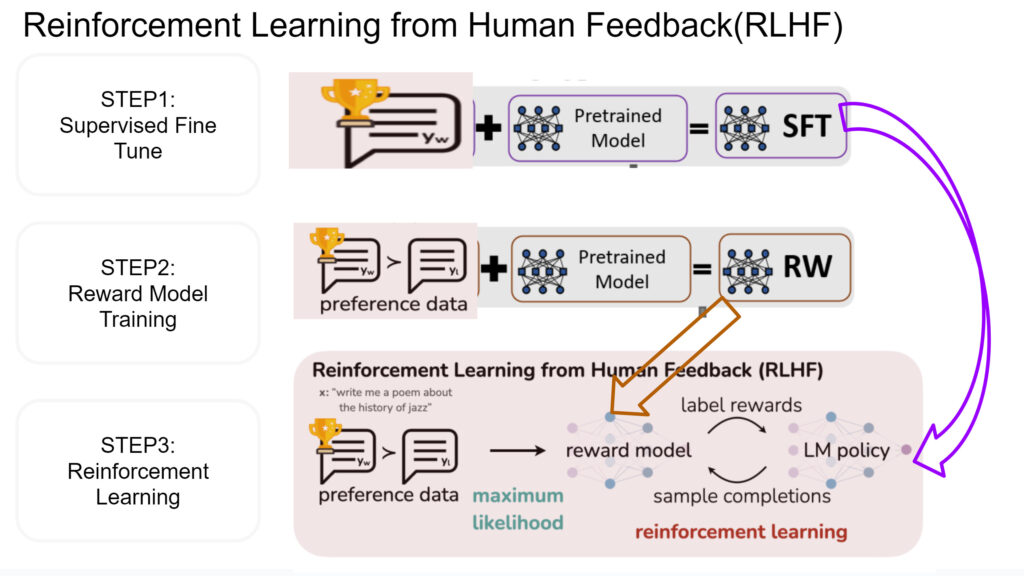

3. 新たなファインチューニング手法「Preference Fine-Tuning」

- 好みに応じた調整

モデルの応答をユーザーや開発者の好みに合わせてカスタマイズ可能。 - 主観的なタスクへの効果

トーンやスタイル、クリエイティビティが求められるタスクに特に有用。 - 学習プロセス

モデルの応答を比較して、好ましい出力とそうでない出力を学習。

期待される利点

- 柔軟な適応

開発者がプロジェクトに応じてモデルを自在に調整可能。 - 効率的な推論

トークン消費や処理時間の削減でコスト削減。 - 多様なタスクへの対応

テキスト生成から画像処理、リアルタイム通信まで幅広いニーズをカバー。

提供の詳細と将来の計画

- 提供開始

Tier 5の上位契約者から段階的に展開予定。 - オープンソース化の計画

開発者コミュニティに向けたさらなる環境整備が期待される。

OpenAIによる連続発表の9日目となるこの取り組みは、AIの可能性を拡大し、開発者の創造力を引き出すものとして注目を集めています。

コメント一覧