楽天は、新しい日本語対応の大規模言語モデル(LLM)「Rakuten AI 2.0」と、同社初の小規模言語モデル(SLM)「Rakuten AI 2.0 mini」を発表しました。これらのモデルは、2025年春にオープンソースとして公開される予定です。

「Rakuten AI 2.0」:高性能かつ効率的なLLM

「Rakuten AI 2.0」は、2024年3月に公開された「Rakuten AI 7B」を元に開発され、8つの約70億パラメータで構成されたサブモデル(エキスパート)を持つMoE(Mixture of Experts)アーキテクチャを採用しています。

- 特徴的な仕組み

モデルは入力トークンごとに最適な2つのエキスパートを選んで処理を行い、計算コストを抑えながら高い出力性能を実現します。 - 計算効率

8倍規模の高密度モデルに匹敵する性能を、約1/4の計算コストで提供可能。 - 性能評価

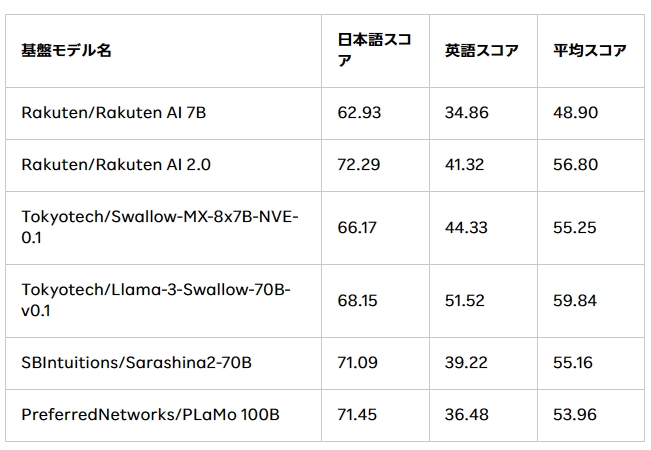

楽天の独自テストでは、「Rakuten AI 7B」に比べて日本語タスクの平均スコアが62.93から72.29に向上しています。

「Rakuten AI 2.0 mini」:軽量で汎用性の高いSLM

約15億パラメータで構成された「Rakuten AI 2.0 mini」は、特にモバイル端末やオンプレミス環境での活用に向けて設計されています。

- データのプライバシー

ローカルで動作するため、リモートサーバーにデータを送信せず、プライバシー保護に優れています。 - 低遅延とコスト効率

特定のアプリケーションにおいて、高速な応答とコスト削減を実現。 - 多言語対応

内製のデータフィルタリングとアノテーションを通じ、日本語と英語での高精度なテキスト生成を可能にしています。

オープンソース化とコミュニティへの貢献

楽天はこれらのモデルをオープンソースコミュニティに公開することで、開発者や企業が活用できる環境を提供します。これにより、日本語対応のAI技術がさらに普及し、楽天独自のGPUクラスターを活用した大規模学習の知見が広がることが期待されています。

「Rakuten AI 2.0」と「2.0 mini」は、日本国内外でのAI活用の新たな可能性を切り開く一歩となるでしょう。これにより、AIの高性能化と効率化が同時に進むと見込まれます。

コメント一覧